Учебный комплект автономных мобильных роботов для изучения операционных систем реального времени

Работаем по 44-ФЗ и 223-ФЗ, прямые договора, через ЕИС, торговые площадки, региональные порталы малых закупок.

Подготавливаем техническое задание для аукционов.

С торгующими организациями и физ. лицами не работаем!

Описание

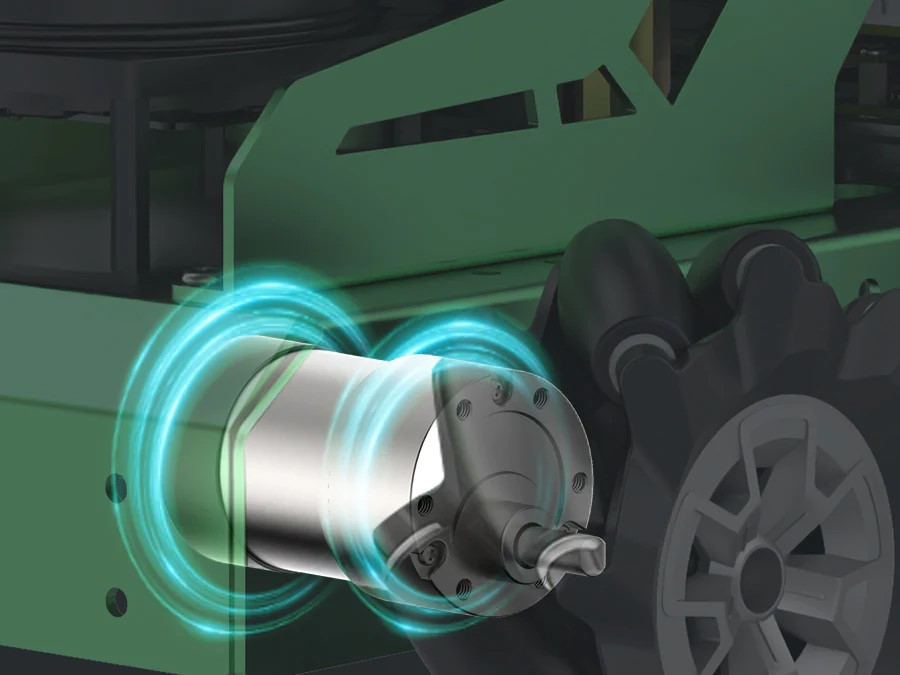

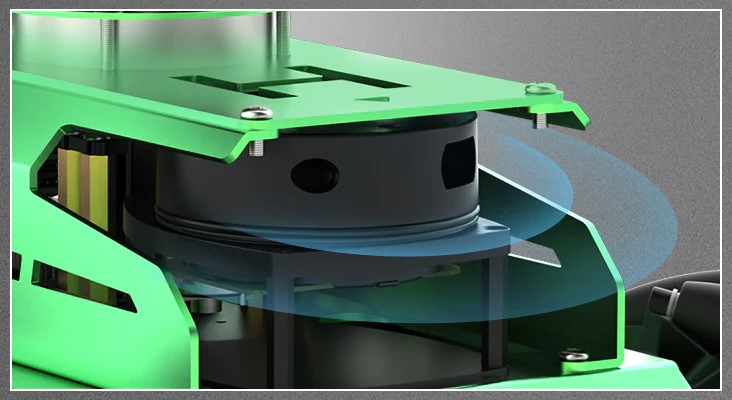

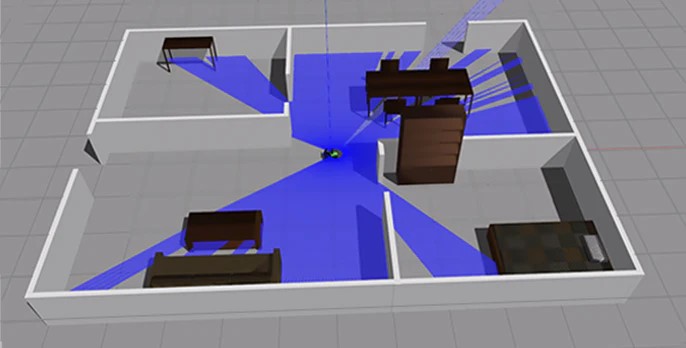

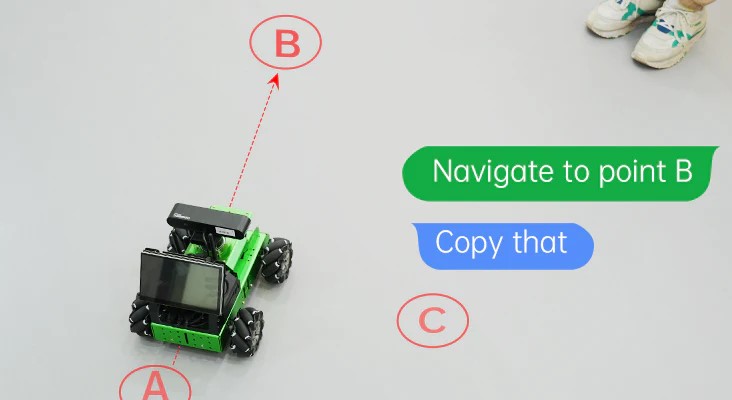

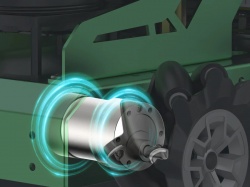

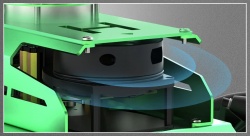

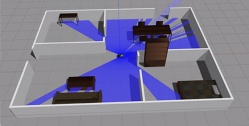

Учебный комплект автономных мобильных роботов для изучения операционных систем реального времени. Он оснащен NVIDIA Jetson Nano, высокопроизводительным моторами, лидаром, 3D-камерой глубины и 7-дюймовым экраном. Картографирование и навигация, планирование пути, отслеживание и предотвращение препятствий, автономное вождение, распознавание человеческих черт, соматосенсорное взаимодействие и голосовое взаимодействие. Автономный мобильный робот использует лидар для обнаружения окружения в режиме реального времени, обеспечивая как одноточечную, так и многоточечную навигацию. Он может перепланировать маршрут, чтобы избежать препятствия и продолжить движение. Автономный мобильный робот может обеспечить навигацию для нескольких транспортных средств, планирование пути и интеллектуальное предотвращение препятствий.

Возможности набора:

- NVIDIA Jetson Nano может запускать основные платформы глубокого обучения, такие как TensorFlow, PyTorch, Caffe/Caffe2, Keras, MXNet.

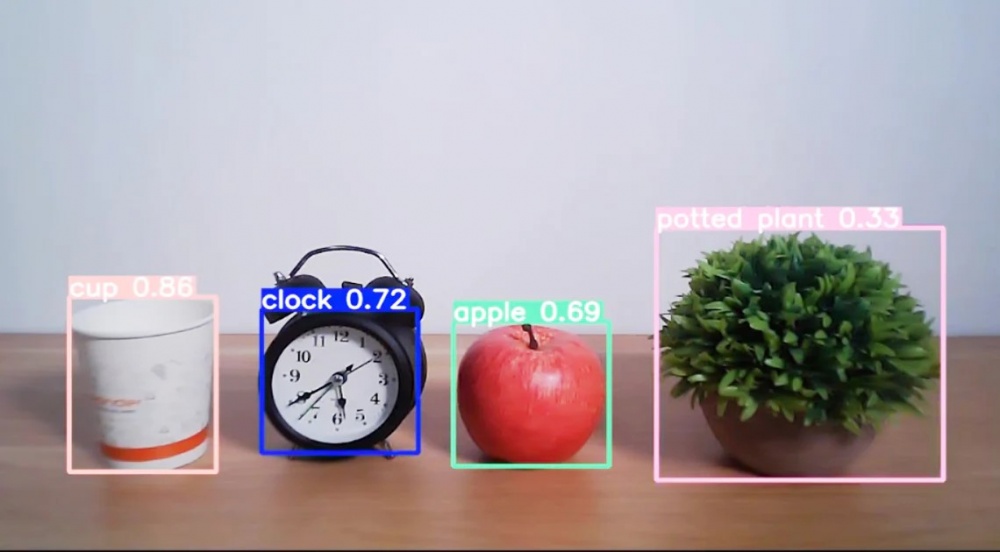

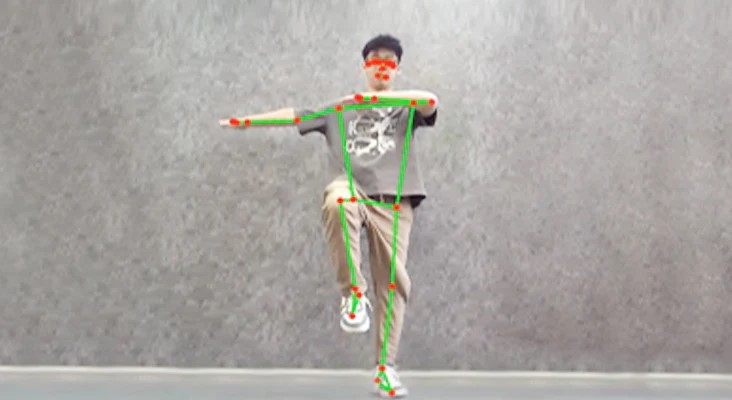

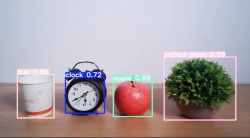

- Учебный комплект на базе Jetson Nano может реализовывать распознавание изображений, обнаружение и позиционирование объектов, оценку позы, семантическую сегментацию, интеллектуальный анализ.

- Учебный комплект оснащен высокопроизводительным лидаром, который поддерживает картографирование с использованием различных алгоритмов, включая Gmapping, Hector, Karto и Cartographer.

- Возможность реализовать планирование пути, навигацию по фиксированной точке, а также обход препятствий во время навигации.

- Возможность отслеживать препятствие в режиме реального времени во время навигации. Таким образом, он может перепланировать маршрут, чтобы избежать препятствия и продолжить движение.

- Используя алгоритм RRT, может завершить картографирование исследования, сохранить карту и самостоятельно вернуться к исходной точке, поэтому нет необходимости в ручном управлении.

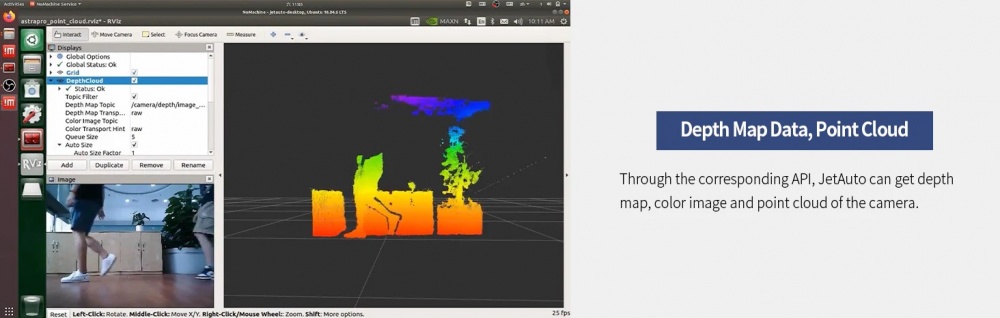

- Камера глубины поддерживает 3D-картографирование двумя способами: чистое RTAB-видение и объединение видения, а также лидар, который позволяет автономному мобильному роботу перемещаться и избегать препятствий, как на 3D-карте, так и в реальных условиях.

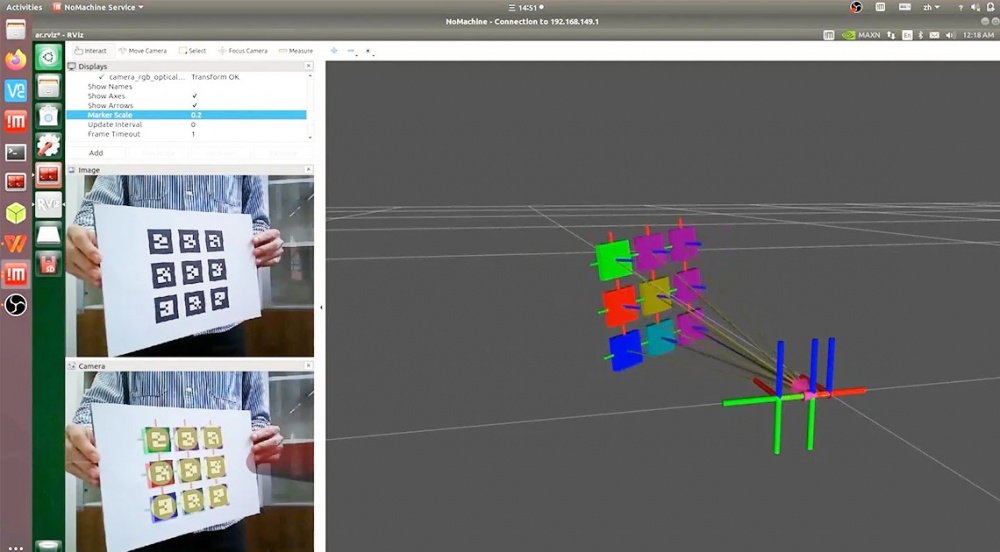

- ORB-SLAM — это платформа SLAM с открытым исходным кодом для монокулярных, бинокулярных камер и камер RGB-D, которая способна вычислять траекторию камеры в реальном времени и реконструировать трехмерное окружение. А в режиме RGB-D можно получить реальный размер объекта через соответствующий API может получить карту глубины, цветное изображение и облако точек камеры.

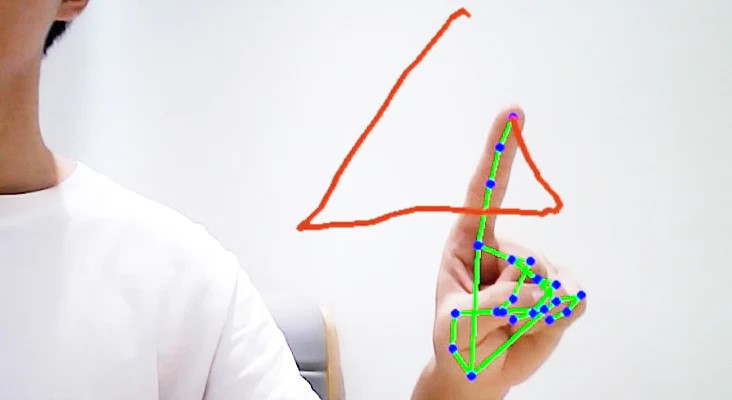

- На основе платформы MediaPipe может выполнять распознавание человеческого тела, кончиков пальцев, лиц, 3D-обнаружение и многое другое.

- Используйте сетевой алгоритм YOLO и библиотеку моделей глубокого обучения для распознавания объектов.

- Опираясь на алгоритм фильтрации KCF, робот может отслеживать выбранную цель, способен распознавать и отслеживать назначенный цвет, а также одновременно распознавать несколько QR кодов и их координаты.

- Возможность работать с кинематической имитационной моделью URDF.

- 6-микрофонная матрица отлично справляется с локализацией источника звука в дальней зоне, распознаванием голоса и голосовым взаимодействием. По сравнению с обычным микрофонным модулем он может реализовывать более продвинутые функции.

- Возможность связи между несколькими машинами может обеспечить навигацию для нескольких транспортных средств, планирование пути и интеллектуальное предотвращение препятствий.

Уровни обучения:

- Исследовательский уровень: Знакомство со сложной кинематикой, основы тригонометрии, углубленное изучение текстовых языков программирования, изучение физических основ работы датчиков.

- Продвинутый уровень: Изучить алгоритмы поиска пути: A*, Dijkstra, RRT, PRM, Развитие навыков планирования движения: локальное и глобальное планирование, планирование траекторий. Распознавания графических маркеров, распознавание массивов линий и элементов дорожных знаков и разметки, картография, распознавание направления источника звука. Способы использования роботов и глубокого обучения для автоматизации различных процессов. Визуализация облака точек

Состав:

| Робот в сборе | 1 шт. |

| Антенна | 2 шт. |

| Адаптер питания на 12 Вольт 5A | 1 шт. |

| LCD дисплей 7 дюмов | 1 шт. |

| Картридер | 1 шт. |

| Кронштейн для экрана | 1 шт. |

| Камера глубины | 1 шт. |

| CD карта | 1 шт. |

| Отвертка крестовая | 1 шт. |

| Метки с кодом | 3 шт. |

| Цветные кубики | 3 шт. |

| Набор метизов | 1 шт. |

Характеристики:

| основное общее образование | |

| Артикул | HW2019223 |

| Бренд | Техник |

Рекомендуем

Образовательный набор для изучения мобильных робототехнических систем с возможностью машинного обучения "Мастер ИН". Продвинутый уровень

Учебный комплект автономных мобильных роботов для изучения операционных систем реального времени

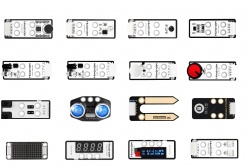

Универсальный комплект датчиков ко всей линейки конструкторов Техник

MS0061 Набор игрушек "Математические лабиринты" (с системой хранения)

«Игровоз» - модульный органайзер в виде паровоза для детского сада

Стол для занятий конструированием и моделированием «Собирайкин»

Многофункциональный обучающий интерактивный комплекс по здоровьесбережению “Будь здоров!

Интерактивный комплекс гражданско-патриотического воспитания «Родная страна»

Методический интерактивный стол «АЛМА Финансовая грамотность» для школ 43"

Цифровая лаборатория для начальной школы (6 рабочих мест для 12 учеников и рабочее место учителя)

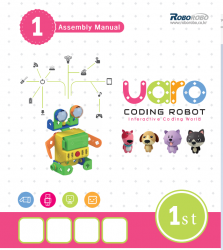

Конструктор по робототехники и алгоритмики UARO - базовый набор (Step 1) арт. 1122311

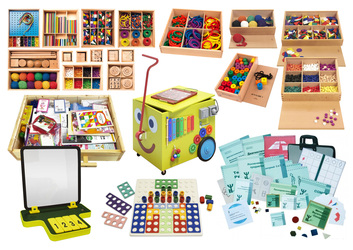

Набор для логопеда, дефектолога и специалиста по ранней помощи

«English Buddy PRO» - Интерактивный комплекс для кружков английского языка

Товар «Учебный комплект автономных мобильных роботов для изучения операционных систем реального времени» добавлен в корзину